唠唠资讯2025年10月27日 13:46消息,字节跳动推出Seed3D 1.0,一键将2D图片转为3D模型,开启视觉新体验。

10月23日,字节跳动旗下Seed团队正式发布其全新自研的3D生成大模型——Seed3D 1.0,标志着公司在生成式AI与三维内容创作领域的又一重要突破。该模型实现了从单张二维图像到高质量、仿真级3D模型的端到端生成,为虚拟现实、具身智能训练、数字孪生等前沿技术提供了强有力的内容生成支持。

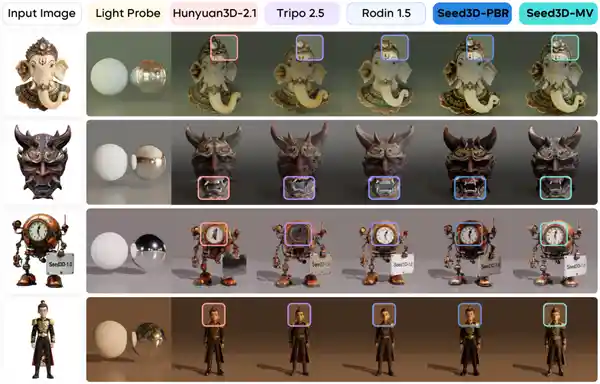

据悉,Seed3D 1.0基于当前生成式AI领域备受关注的Diffusion Transformer架构构建,并通过大规模数据集进行训练。这一技术路径不仅提升了模型的生成效率,还显著增强了输出结果的细节表现力。模型能够生成具备精细几何结构、真实感纹理以及符合物理渲染(PBR)标准的完整3D资产,极大程度满足了工业级应用对视觉真实性和材质准确性的严苛要求。

尤为值得关注的是,Seed3D 1.0生成的3D模型可无缝接入如NVIDIA Isaac Sim等主流仿真引擎,仅需少量适配工作即可用于具身智能大模型的训练任务。这意味着AI系统可以在高度仿真的虚拟环境中学习和进化,从而加速机器人、自动驾驶等领域的发展进程。从这个角度看,Seed3D不仅是内容工具的升级,更是推动人工智能“具身化”落地的关键基础设施。

在应用场景拓展方面,Seed3D 1.0采用了分步式场景生成策略,能够从单一物体建模逐步扩展至构建完整且逻辑连贯的3D场景。这种由点到面的生成能力,使得模型在游戏开发、元宇宙构建、虚拟城市模拟等复杂场景中展现出巨大潜力。相较于传统手动建模或依赖多阶段算法拼接的方式,Seed3D实现了更高效率与一致性。

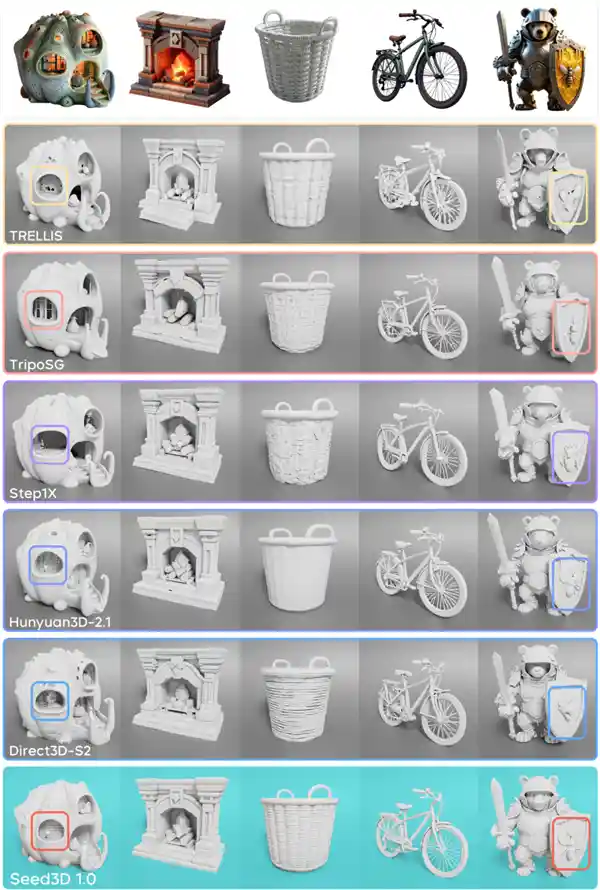

根据公开测试数据,Seed3D 1.0在多个关键指标上超越现有模型:其纹理与材质生成质量优于当前已知的开源及闭源方案;几何重建精度甚至超过参数规模更大的同类模型,综合性能达到行业领先水平。这表明,模型并非单纯依靠“堆参数”取胜,而是通过架构创新和训练优化实现了更高效的表达能力。

目前,Seed3D 1.0的技术报告已对外公开,开发者可通过官方API接口进行调用和集成,项目主页及体验入口也已同步上线。此举体现了字节跳动在AI开源生态建设上的积极姿态,也为学术界和产业界提供了宝贵的实践参考。可以预见,随着更多开发者加入,围绕Seed3D的应用生态将迅速成型。

从技术路线来看,Seed3D 1.0选择Diffusion Transformer作为核心架构,反映出业界对扩散模型与时序建模范式的深度融合趋势的认可。相比传统的U-Net结构,DiT在长距离依赖建模和全局一致性控制方面更具优势,尤其适合处理3D空间中复杂的拓扑关系。这一选择也预示着未来生成式AI将更加注重“结构理解”而非单纯的“模式复制”。

值得一提的是,尽管当前3D生成模型百花齐放,但真正能实现“高质量+易用性+可扩展性”三者统一的产品仍属凤毛麟角。Seed3D 1.0的推出,不仅填补了国内在此领域的空白,也在全球竞争格局中发出了中国企业的强音。它不仅仅是技术成果的展示,更是一种对未来人机交互方式的深刻思考——当AI可以“看图造物”,我们离真正的虚拟世界还有多远?